近期,一起针对苹果公司的诉讼案件引起了广泛关注。这起案件涉及苹果在2022年取消的儿童性虐待材料(CSAM)检测计划,该计划原本旨在通过设备端哈希值系统扫描iCloud中的图片,以检测和阻止CSAM的传播。

一位现年27岁的女性,曾在童年时期遭受性虐待,她以化名对苹果公司提起了诉讼。原告声称,苹果违背了其保护受害者的承诺,特别是在CSAM检测功能被取消后,她遭受性虐待的图片被上传到iCloud并广泛传播。这一发现是在执法部门通知她后得知的,相关图片是通过在佛蒙特州查获的一台MacBook上传至iCloud的。

原告在诉讼中表示,苹果取消CSAM检测功能的决定,使其遭受性虐待的图片得以继续传播,这等同于向消费者销售了“有缺陷的产品”,对她这样的用户群体造成了严重伤害。为此,她要求苹果改变其做法,并向可能多达2680名其他符合条件的受害者提供赔偿。根据法律,这类受害者每人有权获得至少15万美元的赔偿,如果全部受害者成功获得赔偿,苹果将面临超过12亿美元(约87.28亿元人民币)的赔偿金额。

类似的情况在北卡罗来纳州也发生过。一名9岁的CSAM受害者指控苹果,称她通过iCloud链接收到了陌生人发送的非法视频,并被诱导拍摄并上传了类似内容。苹果对此提出了一项驳回案件的动议,引用联邦法规第230条,试图免除其对用户上传到iCloud的材料的责任。然而,法院近期裁定,这一法律保护仅适用于积极内容审核的情形,这可能削弱了苹果的抗辩理由。

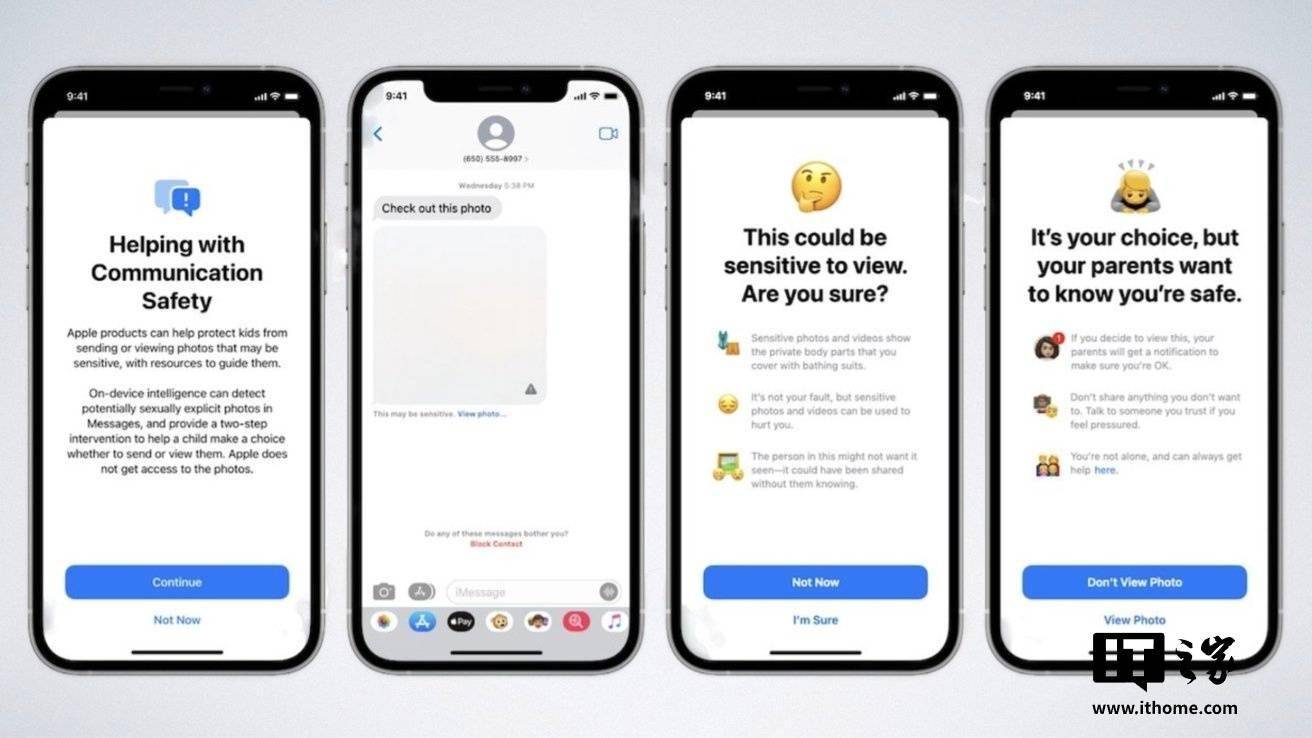

面对新诉讼,苹果发言人弗雷德·塞恩兹表示,苹果认为儿童性虐待材料是极其恶劣的,公司一直致力于在不损害用户隐私和安全的前提下,积极打击相关犯罪。他提到,苹果已经扩展了信息应用中的裸露内容检测功能,并允许用户举报有害材料。然而,原告及其律师玛格丽特·马比认为,苹果的措施还远远不够,未能充分履行其保护受害者的责任。