近日,meta公司首席执行官马克·扎克伯格曾怀揣梦想,誓言要将通用人工智能(AGI)——即能够胜任人类所有任务的人工智能——推向大众。然而,meta最新发布的政策文件却透露出,这家科技巨头在某些特定情境下,可能会对其内部研发的高性能AI系统实施发布限制。

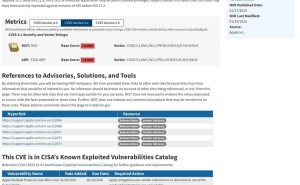

这份名为“前沿人工智能框架”的文件,详细阐述了meta认定的两种发布风险极高的AI系统类型:“高风险”系统与“关键风险”系统。据meta定义,这两类系统均具备协助实施网络攻击、化学攻击及生物攻击的能力。其中,“关键风险”系统的威胁尤为严重,可能导致在拟部署环境中无法控制的灾难性后果,而“高风险”系统虽然也能使攻击更为便捷,但其稳定性和可靠性相对较低。

meta在文件中列举了具体的攻击场景,诸如对企业级环境进行自动化入侵,以及高影响力生物武器的扩散等,并坦言这些案例远非详尽无遗,但它们是meta认为最为紧迫,且最有可能因发布强大AI系统而直接触发的事件。在评估系统风险时,meta并未单纯依赖实证测试,而是综合了内部及外部研究人员的意见,并经由高级别决策者进行审慎审查。meta指出,当前的风险评估科学尚不足以提供明确的量化指标,以确定系统的风险性。

针对被判定为“高风险”的系统,meta将限制其在内部的访问权限,并在实施风险缓解措施,将风险降至中等水平之前,不予发布。而对于“关键风险”系统,meta则将采取未公开的安全防护措施,防止系统被非法获取,并暂停开发,直至系统危险性得以降低。

meta强调,“前沿人工智能框架”将随着AI领域的发展而不断演进。本月,meta还承诺在法国人工智能行动峰会上提前发布该框架,这被视为对公司“开放”开发系统策略所受批评的一种回应。meta一直致力于将人工智能技术公开提供(尽管并非传统意义上的开源),这与将系统置于API背后的OpenAI等公司形成了鲜明对比。

meta在文件中明确表示:“我们坚信,在权衡开发与部署先进人工智能的利弊时,有可能找到一种方式,既能保留该技术对社会的益处,又能将风险控制在适当水平,从而将其安全地推向社会。”