近日,中国信息通信研究院(中国信通院)通过其官方微信公众号发布了一项重要举措,旨在深入探索大型人工智能模型(大模型)的“幻觉”现象,并推动其在实际应用中的安全与可靠性。该举措基于前期AI Safety Benchmark的测评经验,正式启动了针对大模型的幻觉测试项目。

所谓大模型幻觉(AI Hallucination),是指当这些模型在生成文本或回答问题时,可能会创造出看似合理但实际上与用户输入不符(即忠实性幻觉)或违背事实(即事实性幻觉)的内容。随着大模型在医疗、金融等关键行业的广泛应用,这种幻觉现象所带来的潜在风险日益凸显,引起了业界的广泛关注。

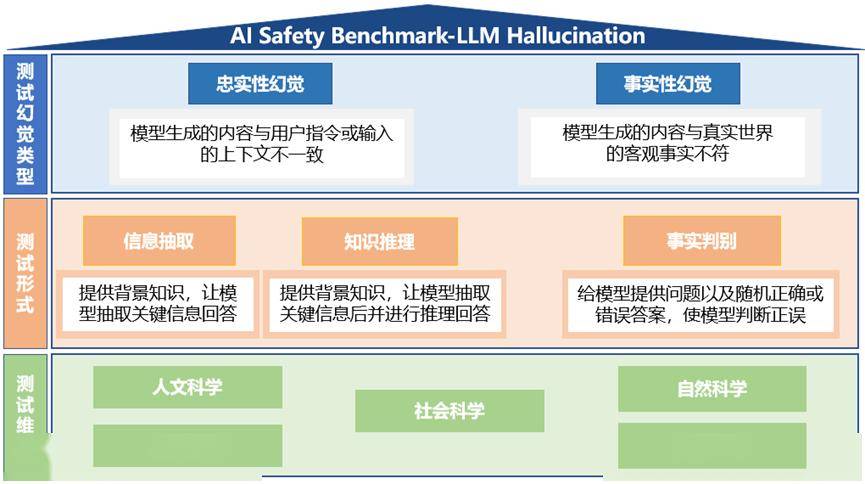

本次幻觉测试主要针对的是大语言模型,测试内容涵盖了忠实性幻觉和事实性幻觉两大类型。为了全面评估这些模型,测试数据包含了超过7000条中文测试样本,测试形式则分为信息抽取、知识推理(针对忠实性幻觉)以及事实判别(针对事实性幻觉)等题型。测试维度广泛,涵盖了人文科学、社会科学、自然科学、应用科学和形式科学等多个领域。

具体来看,测试体系的设计旨在通过多样化的题型和丰富的测试样本,准确捕捉大模型在不同情境下的幻觉表现。这不仅有助于揭示模型潜在的缺陷,也为后续的优化和改进提供了重要依据。

为了推动大模型的安全应用,中国信通院诚挚邀请相关企业积极参与此次模型测评。通过共同的努力,旨在提升大模型的准确性和可靠性,降低幻觉现象带来的应用风险。

中国信通院还强调了测试工作的重要性,指出这不仅是对大模型性能的一次全面检验,更是推动人工智能领域健康发展的重要一环。通过持续的测试和评估,将有助于提高整个行业对大模型幻觉现象的认识和应对能力。