近期,科技界传来一项新进展,谷歌DeepMind团队推出了一项名为QuestBench的全新基准测试,旨在评估大型语言模型(LLMs)在推理任务中识别和填补信息缺口的能力。这一创新举措针对现实世界中信息不完整的问题,为LLMs的发展提供了新的挑战与机遇。

在各类推理任务中,如数学、逻辑、规划和编码等领域,大型语言模型正受到越来越多的关注。然而,实际应用场景往往伴随着大量的不确定性,例如用户提问时可能遗漏关键信息,或机器人等自主系统需要在部分可观测的环境中运行。这种理想与现实之间的差距,使得LLMs必须发展出主动获取缺失信息的能力。

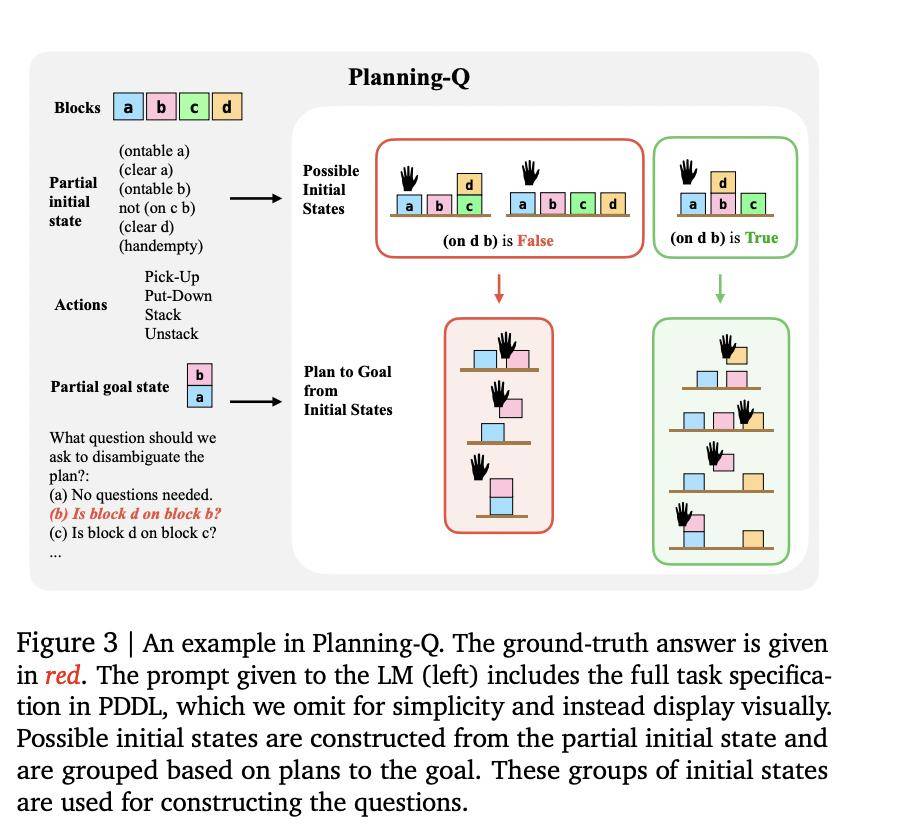

QuestBench基准测试正是为了应对这一挑战而生。它采用约束满足问题(CSPs)的框架,特别关注“1-sufficient CSPs”,即只需一个未知变量的信息即可解决目标变量的问题。该测试覆盖了逻辑推理、规划和小学数学三个领域,通过变量数量、约束数量、搜索深度和暴力搜索所需猜测次数四个维度,对模型的推理策略和性能瓶颈进行精准评估。

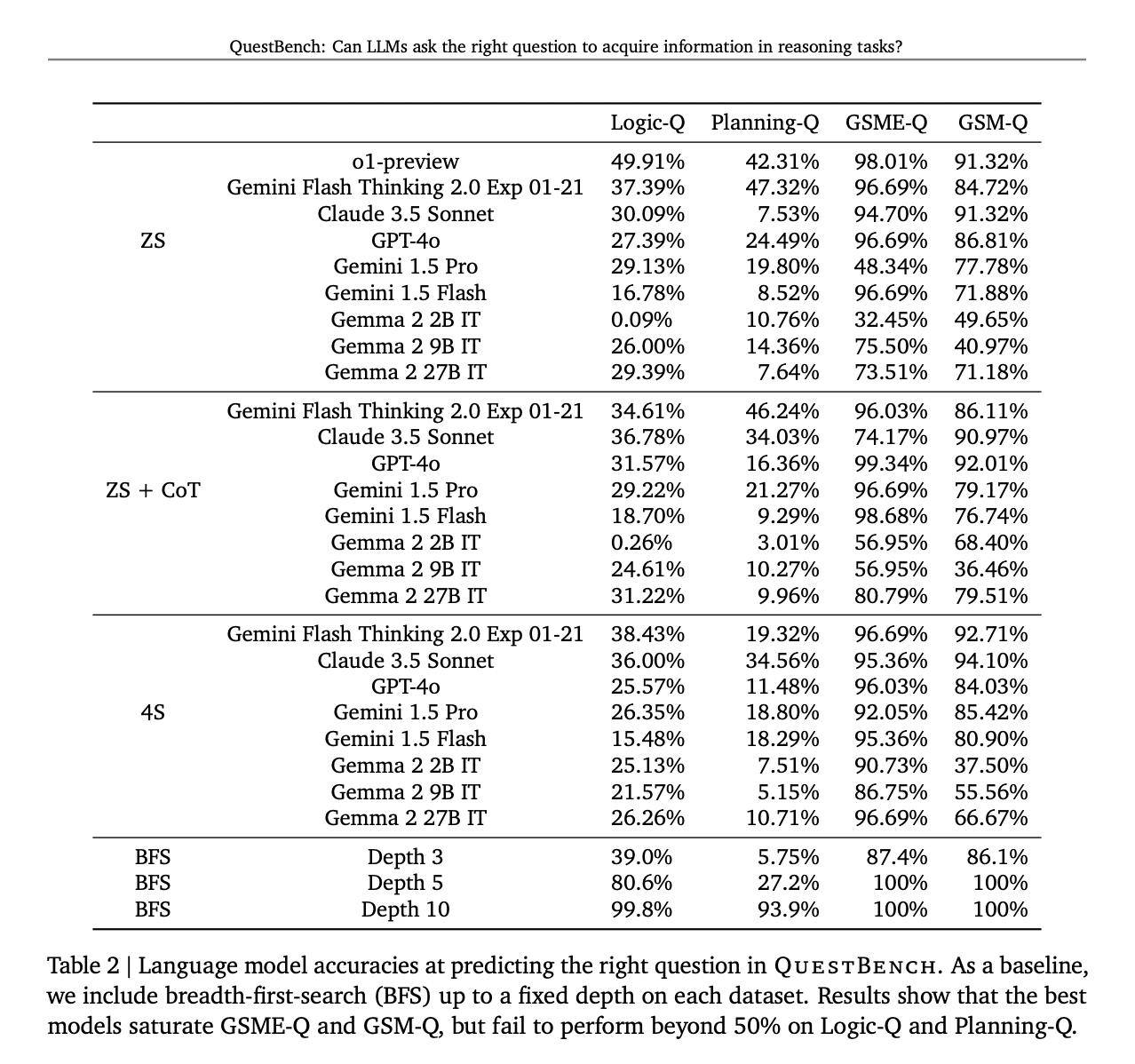

据悉,QuestBench已经对包括GPT-4o、Claude 3.5 Sonnet、Gemini 2.0 Flash Thinking Experimental等在内的多个领先模型进行了测试,测试环境涵盖了零样本、思维链和四样本设置。测试结果显示,思维链提示在提升模型性能方面发挥了普遍作用,而Gemini 2.0 Flash Thinking Experimental在规划任务中展现出了最佳表现。

开源模型在逻辑推理方面表现出了一定的竞争力,但在处理复杂的数学问题时则显得力不从心。研究指出,尽管当前模型在解决简单代数问题上表现尚可,但随着问题复杂性的增加,其性能显著下降。这一发现揭示了LLMs在信息缺口识别和澄清能力方面仍有较大的改进空间。

QuestBench基准测试的推出,不仅为评估LLMs在推理任务中的性能提供了新的工具,也为推动LLMs在信息获取和推理能力方面的发展指明了方向。随着技术的不断进步,我们有理由相信,未来的LLMs将能够更好地应对现实世界中的不确定性,为人类提供更加准确和可靠的解决方案。

QuestBench测试还涵盖了288个GSM-Q和151个GSME-Q任务,这些任务的设计充分考虑了现实世界的复杂性,使得测试结果更加贴近实际应用场景。通过这一基准测试,我们可以更加清晰地了解LLMs在不同领域和难度下的表现,从而为模型的进一步优化和改进提供有力支持。